Hadoop伪分布式搭建 [ 哔哔大数据 ]

大数据男孩 文章 正文

明妃

{{nature("2022-08-14 17:23:14")}}更新[ ]()

]()

搭建版本

0x00 配置 jdk 的环境变量

0x01 配置 hadoop 的环境变量

-

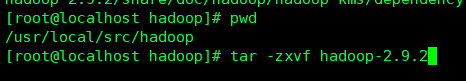

创建 hadoop 文件,解压 hadoop 的tar包

创建文件夹 mkdir /usr/local/src/hadoop/ 解压 hadoop tar -zxvf hadoop-2.9.2 -

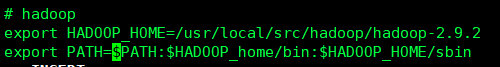

配置hadoop环境变量

vi /etc/profile

# hadoop

export HADOOP_HOME=/usr/local/src/hadoop/hadoop-2.9.2

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

修改完成后记得 source /etc/profile

0x02 修改 Hadoop 相关文件

- 修改

hadoop-env.sh

-

路径

hadoop-2.9.2/etc/hadoop/hadoop-env.sh-

第一处修改 加入 JAVA_HOME 的路径 [

]()

]() -

第二处修改

-

加入 HADOOP_HOME 路径

export HADOOP_HOME=/usr/local/src/hadoop/hadoop-2.9.2 export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop[

]()

]() -

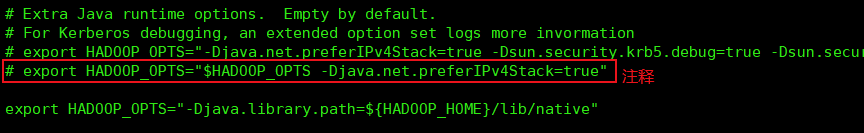

第三处修改

export HADOOP_OPTS="-Djava.library.path=${HADOOP_HOME}/lib/native"[

]()

]()

-

-

记得

source hadoop-env.sh

-

2 修改

core-site.xml-

路径

hadoop-2.9.2/etc/hadoop/core-site.xml -

创建临时目录

mkdir -p /usr/local/src/hadoop/tmp/name/

-

<configuration>

<!--指定hdfs的老大,namenode的地址-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://本机ip地址:9000</value>

</property>

<!--指定hadoop运行时产生的文件存放的地址-->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/src/hadoop/tmp</value>

</property>

</configuration>-

3 修改

hdfs-site.xml- 路径

hadoop-2.9.2/etc/hadoop/hdfs-site.xml

- 路径

<configuration>

<!--指定hdfs保存数据副本数量,默认值是3-->

<!--如果是伪分布式,此值是 1 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!--设置hdfs的操作权限,false 表示任何用户都可以在 hdfs 上操作文件-->

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

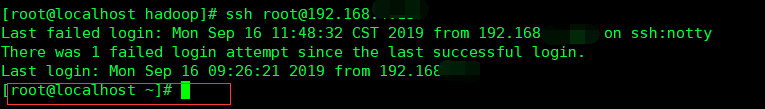

</configuration>0x03 配置免密登录

0x04 启动 hadoop

- 格式化节点

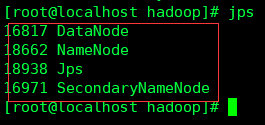

hdfs namenode ‐format - 启动 hadoop

start-dfs.sh- 出现下图则伪分布式安装成功

[

]()

]()

- 出现下图则伪分布式安装成功

[

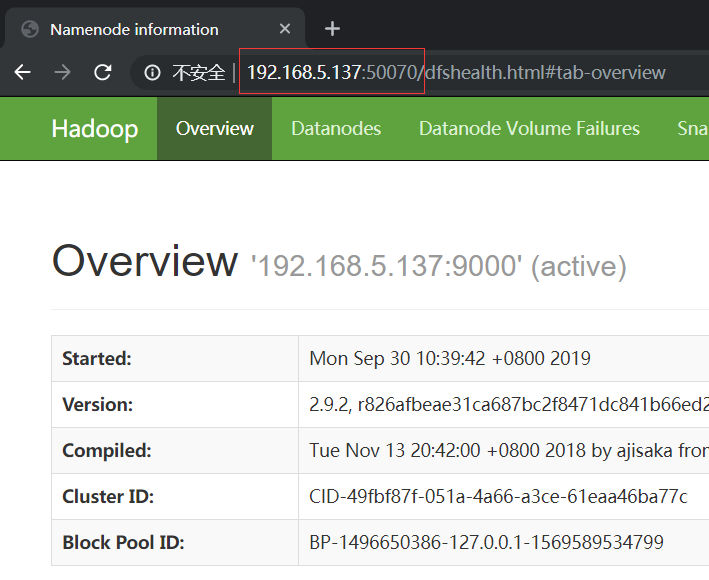

0x05 查看Hadoop的网页端

- 打开浏览器输入

IP:50070即可 [ ]()

]()

推荐阅读:伪分布式相关问题及解决方法

{{nature('2020-01-02 16:47:07')}} {{format('12522')}}人已阅读

{{nature('2019-12-11 20:43:10')}} {{format('9410')}}人已阅读

{{nature('2019-12-26 17:20:52')}} {{format('7405')}}人已阅读

{{nature('2019-12-26 16:03:55')}} {{format('4880')}}人已阅读

目录

标签云

一言

评论 0

{{userInfo.data?.nickname}}

{{userInfo.data?.email}}